CONDICIONAMIENTO OPERANTE I

EL CONDICIONAMIENTO OPERANTE

CONDUCTA OPERANTE:

Propósito y Conducta

Debido a los efectos que produce el ambiente la conducta, se asigna una cualidad o propiedad de propositividad a la conducta, a fin de traer al presente efectivo “lo que hace el organismo emitir la conducta” o bien, se dice que el organismo se comporta de una manera determinada debido a que tiene la intención de lograr, o que espera obtener, un efecto dado; o se caracteriza a la conducta como poseyendo utilidad en tanto maximice o minimice ciertos efectos.

La ley del efecto de Thorndike, dio el paso en esa dirección: la ocurrencia aproximadamente simultánea de una respuesta, y ciertos eventos ambientales (comúnmente generados por ella), cambian las respuestas del organismo, aumentando la probabilidad de que ocurran de nuevo las respuestas de la misma especie. En sí misma, la respuesta ha pasado a la historia y no es alterada. Thorndike hizo lo posible por incluir los efectos de la acción entre las causas de la acción futura sin usar conceptos como propósitos, intención, expectativa, utilidad.

La ley del efecto agregó una nueva clase de variables importantes, de las que podía demostrarse que la conducta era una función. Los aparatos utilizados para el estudio de la conducta durante el siguiente cuarto de siglo continuaron enfatizando una relación de intencionalidad entre la conducta y sus consecuencias.

Una vez que el procedimiento se hizo común, no resultó difícil diseñar un aparato en el cual una respuesta produjese alimento de una manera similar.

Uno de los colaboradores de Pavlov –Ivanov Esmoloensky- estudió una disposición experimental análoga a la de Thorndike. A pesar de saber como o porqué siguen a la conducta, las consecuencias de una acción cambian al organismo. La conexión no necesita ser funcional u orgánica, como en realidad no lo fue en el experimento de Thorndike.

Ventajas y Prácticas.

Los primeros aparatos no fueron diseñados para eliminar las representaciones espaciales de la positividad; sin embargo, así lo hicieron, y este hecho tuvo consecuencias de gran alcance. El experimentador podía elegir una respuesta que era convenientemente registrada, o una que el organismo pudiera ejecutar sin fuerza por tiempos prolongados.

Una respuesta que sólo se relaciona de modo temporal con sus consecuencias, también podría estudiarse convenientemente mediante el empleo de equipos automáticos. La disponibilidad del equipo automático ha ayudado a realizar experimentos y ha facilitó el estudio de relaciones entre respuestas y consecuencias tan complejas como para disponerlas en forma manual o inspeccionarlas ocularmente.

Otro resultado práctico fue terminológico. El concepto de Reflejo no hacía referencia a las consecuencias de una respuesta. Con frecuencia los reflejos eran obviamente protectores de daño; pero este era un efecto primordialmente filogenético. El término Operante se estableció para diferenciar los Reflejos de las Respuestas que operan directamente en el ambiente.

El término alternativo, Instrumental, sugiere el uso de instrumentos. Es decir, que una rata usa la palanca para obtener alimento, tiene matices propositivos y en los casos donde no hay indicios que puedan identificar a algo como un instrumento, frecuentemente se dice que el organismo usa la respuesta para obtener un efecto.

Otro cambio fue de Recompensa a Refuerzo. Recompensar sugiere compensación por comportarse de una manera determinada, frecuentemente como en una especie de contrato; el Término Refuerzo, en su sentido etimológico, simplemente señala EL FORTALECIMIENTO DE UNA RESPUESTA.

La Taza de respuesta como un dato

Un resultado importante del estudio de una relación arbitraria entre una respuesta y sus consecuencias, además de la simplificación en los procesos del que se llegó a disponer, ha sido el énfasis que ha sido puesto en la taza de respuestas como una propiedad de la conducta. Los primeros aparatos casi siempre se usaron para estudiar las respuestas de ensayo a ensayo, en las cuales las tazas de respuesta son controladas por el experimentador. En un registro acumulativo, la taza y los cambios en la taza son notorios a primera vista sobre períodos sustanciales. El registro automático permite al experimentador advertir los cambios conforme ocurren, así como seguir los pasos apropiados.

La taza de respuesta resulta importante además de que es apropiada para el análisis principal.

Burrhus Frederic Skinner

Biografía

Burrhus Frederic Skinner nació el 20 de marzo de 1904 en la pequeña ciudad de Susquehanna en Pensilvania. Su padre era abogado y su madre una inteligente y fuerte ama de casa. Su crianza fue al viejo estilo y de trabajo duro.

Burrhus era un chico activo y extravertido que le encantaba jugar fuera de casa y construir cosas y de hecho, le gustaba la escuela. Sin embargo, su vida no estuvo exenta de tragedias. En particular, su hermano murió a los 16 años de un aneurisma cerebral.

Burrhus recibió su graduado en Inglés del Colegio Hamilton en el norte de Nueva York. No encajó muy bien sus años de estudio y ni siquiera participó de las fiestas de las fraternidades de los juegos de fútbol. Escribió para el periódico de la universidad, incluyendo artículos críticos sobre la misma, la facultad e incluso contra ¡Phi Beta Kappa!. Para rematar todo, era un ateo (en una universidad que exigía asistir diariamente a la capilla).

Al final, se resignó a escribir artículos sobre problemas laborales y vivió por un tiempo en Greenwich Village en la ciudad de Nueva York como “bohemio”. Después de algunos viajes, decidió volver a la universidad; esta vez a Harvard. Consiguió su licenciatura en psicología en 1930 y su doctorado en 1931; y se quedó allí para hacer investigación hasta 1936.

También en este año, se mudó a Mineápolis para enseñar en la Universidad de Minesota. Allí conoció y más tarde se casó con Ivonne Blue. Tuvieron dos hijas, de las cuales la segunda se volvió famosa como la primera infante que se crió en uno de los inventos de Skinner: la cuna de aire. Aunque no era más que una combinación de cuna y corral rodeada de cristales y aire acondicionado, parecía más como mantener a un bebé en un acuario.

En 1945 adquirió la posición de jefe del departamento de psicología en la Universidad de Indiana. En 1948 fue invitado a volver a Harvard, donde se quedó por el resto de su vida. Era un hombre muy activo, investigando constantemente y guiando a cientos de candidatos doctorales, así como escribiendo muchos libros. Aunque no era un escritor de ficción y poesía exitoso, llegó a ser uno de nuestros mejores escritores sobre psicología, incluyendo el libro Walden two, un compendio de ficción sobre una comunidad dirigido por sus principios conductuales. Nos referiremos a partir de aquí al término conductual, por ser más apropiado dentro del campo de la psicología. N.T.

El 18 de agosto de 1990, Skinner muere de leucemia, después de convertirse probablemente en el psicólogo más famoso desde Sigmund Freud.

MODELO DE SKINNER

Al Igual que Pavlov, Watson y Thorndike, Skinner creía en los patrones estímulo-respuesta de la conducta condicionada. Su historia tiene que ver con cambios observables de conducta ignorando la posibilidad de cualquier proceso que pudiera tener lugar en la mente de las personas. El libro de Skinner publicado en 1948, Walden Two, presenta una sociedad utópica basada en el condicionamiento operante.

También escribió Ciencia y Conducta Humana, (1953) en el cual resalta la manera en que los principios del condicionamiento operatorio funcionan en instituciones sociales tales como, gobierno, el derecho, la religión, la economía y la educación.

El trabajo de Skinner difiere de sus predecesores (condicionamiento clásico), en que él estudió la conducta operatoria (conducta voluntaria usada en operaciones dentro del entorno).

El sistema de Skinner al completo está basado en el condicionamiento operante. El organismo está en proceso de “operar” sobre el ambiente, lo que en términos populares significa que está irrumpiendo constantemente; haciendo lo que hace.

Durante esta “operatividad”, el organismo se encuentra con un determinado tipo de estímulos, llamado estímulo reforzador, o simplemente reforzador. Este estímulo especial tiene el efecto de incrementar el operante (esto es; el comportamiento que ocurre inmediatamente después del reforzador).

Esto es el condicionamiento operante: el comportamiento es seguido de una consecuencia, y la naturaleza de la consecuencia modifica la tendencia del organismo a repetir el comportamiento en el futuro.”

REFUERZO: TODA INSTANCIA QUE LLEVE A INCREMENTAR LA FRECUENCIA DE RESPUESTA DEL ORGANISMO

El refuerzo SIEMPRE INCREMENTA la frecuencia de respuesta del organismo…

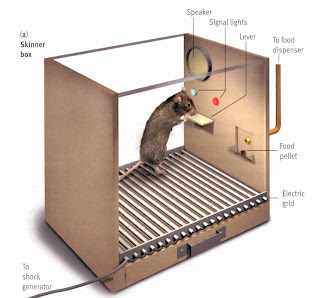

Imagínese a una rata en una caja. Esta es una caja especial (llamada, de hecho, “la caja de Skinner”) que tiene un pedal o barra en una pared que cuando se presiona, pone en marcha un mecanismo que libera una bolita de comida. La rata corre alrededor de la caja, haciendo lo que las ratas hacen, cuando “sin querer” pisa la barra y ¡presto!, la bolita de comida cae en la caja.

Lo operante es el comportamiento inmediatamente precedente al reforzador (la bolita de comida). Prácticamente de inmediato, la rata se retira del pedal con sus bolitas de comida a una esquina de la caja.

Un comportamiento seguido de un estímulo reforzador provoca una probabilidad incrementada de ese comportamiento en el futuro.

¿Qué ocurre si no le volvemos a dar más bolitas a la rata? Aparentemente no es tonta y después de varios intentos infructuosos, se abstendrá de pisar el pedal. A esto se le llama extinción del condicionamiento operante.

Un comportamiento que ya no esté seguido de un estímulo reforzador provoca una probabilidad decreciente de que ese comportamiento no vuelva a ocurrir en el futuro.

Ahora, si volvemos a poner en marcha la máquina de manera que el presionar la barra, la rata consiga el alimento de nuevo, el comportamiento de pisar el pedal surgirá de nuevo, mucho más rápidamente que al principio del experimento, cuando la rata tuvo que aprender el mismo por primera vez. Esto es porque la vuelta del reforzador toma lugar en un contexto histórico, retroactivándose hasta la primera vez que la rata fue reforzada al pisar el pedal.

Esquemas De Refuerzo

Skinner menciona que llegó a sus diversos descubrimientos de forma accidental (operativamente). Por ejemplo, menciona que estaba “bajo de provisiones” de bolitas de comida, de manera que él mismo tuvo que hacerlas; una tarea tediosa y lenta. De manera que tuvo que reducir el número de refuerzos que le daba a sus ratas para cualquiera que fuera el comportamiento que estaba intentando condicionar. Así que, las ratas mantuvieron un comportamiento constante e invariable, ni más ni menos entre otras cosas, debido a estas circunstancias. Así fue como Skinner descubrió los esquemas de refuerzo.

El refuerzo continuo es el escenario original: cada vez que la rata comete el comportamiento (como pisar el pedal), consigue una bolita de comida.

TAZA: Numero de veces que se da una conducta por unidad de tiempo

TAZA FIJA El programa de frecuencia fija fue el primero que descubrió Skinner: si, digamos, la rata pisa tres veces el pedal, consigue comida. O cinco. O veinte. O “x” veces. Existe una frecuencia fija entre los comportamientos y los refuerzos: 3 a 1; 5 a 1; 20 a 1, etc. Es como una “tasa por pieza” en la producción industrial de ropa: cobras más mientras más camisetas hagas.

INTERVALO FIJO El programa de intervalo fijo utiliza un artilugio para medir el tiempo. Si la rata presiona el pedal por lo menos una vez en un período de tiempo particular (por ejemplo 20 segundos), entonces consigue una bolita de comida. Si falla en llevar a cabo esta acción, no consigue la bolita. Pero, ¡aunque pise 100 veces el pedal dentro de ese margen de tiempo, no conseguirá más de una bolita!. En el experimento pasa una cosa curiosa si la rata tiende a llevar el “paso”: bajan la frecuencia de su comportamiento justo antes del refuerzo y aceleran la frecuencia cuando el tiempo está a punto de terminar.

TAZA VARIABLE Una frecuencia variable significa que podemos cambiar la “x” cada vez; primero presiona tres veces para conseguir una bolita, luego 10, luego 1, luego 7 y así sucesivamente. El intervalo variable significa que mantenemos cambiante ese período; primero 20 segundos, luego 5; luego 35 y así sucesivamente.

INTERVALO VARIABLE Siguiendo con el programa de intervalos variables, Skinner también observó en ambos casos que las ratas no mantenían más la frecuencia, ya que no podían establecer el “ritmo” por mucho tiempo más entre el comportamiento y la recompensa. Más interesantemente, estos programas eran muy resistentes a la extinción.

Pensándolo detenidamente… verdaderamente tiene sentido. Si no hemos recibido una recompensa por un tiempo, bueno, es muy probable que estemos en un intervalo o tasa “errónea”…¡sólo una vez más sobre el pedal; Quizás ésta sea la definitiva!.

De acuerdo con Skinner, este es el mecanismo del juego. Quizás no ganemos con demasiada frecuencia, pero nunca sabemos cuando ganaremos otra vez. Puede que sea la inmediatamente siguiente, y si no lanzamos los dados o jugamos otra mano o apostamos a ese número concreto, ¡perderemos el premio del siglo!

0 Comments:

Post a Comment

<< Home